一、机器学习中的公平性、偏见与伦理挑战

在当今数字化时代,机器学习技术正以惊人的速度改变着我们的生活和工作方式。从个性化推荐系统到医疗诊断工具,再到金融风险评估模型,机器学习的应用无处不在。然而,随着其广泛应用,一些关键问题也逐渐浮出水面,其中最为突出的便是公平性、偏见以及伦理问题。这些问题不仅关乎技术的正确性,更关乎社会的公正与和谐。机器学习模型的决策过程往往基于大量数据,而这些数据可能本身就带有偏见,从而导致模型在应用中对某些群体产生不公平的待遇。例如,在招聘过程中,一个带有性别偏见的机器学习模型可能会不公正地筛选候选人;在司法领域,一个存在种族偏见的算法可能会对不同种族的被告产生不同的判决倾向。此外,机器学习的伦理问题也引发了广泛的讨论,比如数据隐私保护、算法的透明度以及模型的可解释性等。这些问题的复杂性在于,它们不仅仅是技术问题,更是社会、文化和法律问题的交织。因此,深入探讨机器学习中的公平性、偏见和伦理问题,不仅是为了技术的完善,更是为了构建一个更加公正、包容和可持续的数字社会。

二、机器学习中的偏见实例

这幅图片列出了机器学习领域中存在的偏见问题。具体包括:

招聘工具对女性存在歧视。

面部识别系统将肤色较深的人与罪犯照片进行错误匹配。

银行贷款批准过程中存在偏见。

加强负面刻板印象的有害影响。

三、机器学习技术的负面应用

这幅图片列出了机器学习领域的一些不良使用案例,包括:

深度伪造(Deepfakes):利用机器学习技术生成逼真但虚假的图像或视频。

通过优化参与度来传播有毒或煽动性言论。

为商业或政治目的生成虚假内容。

使用机器学习构建有害产品或进行欺诈等犯罪活动。

垃圾邮件与反垃圾邮件之间的对抗:欺诈与反欺诈之间的斗争。

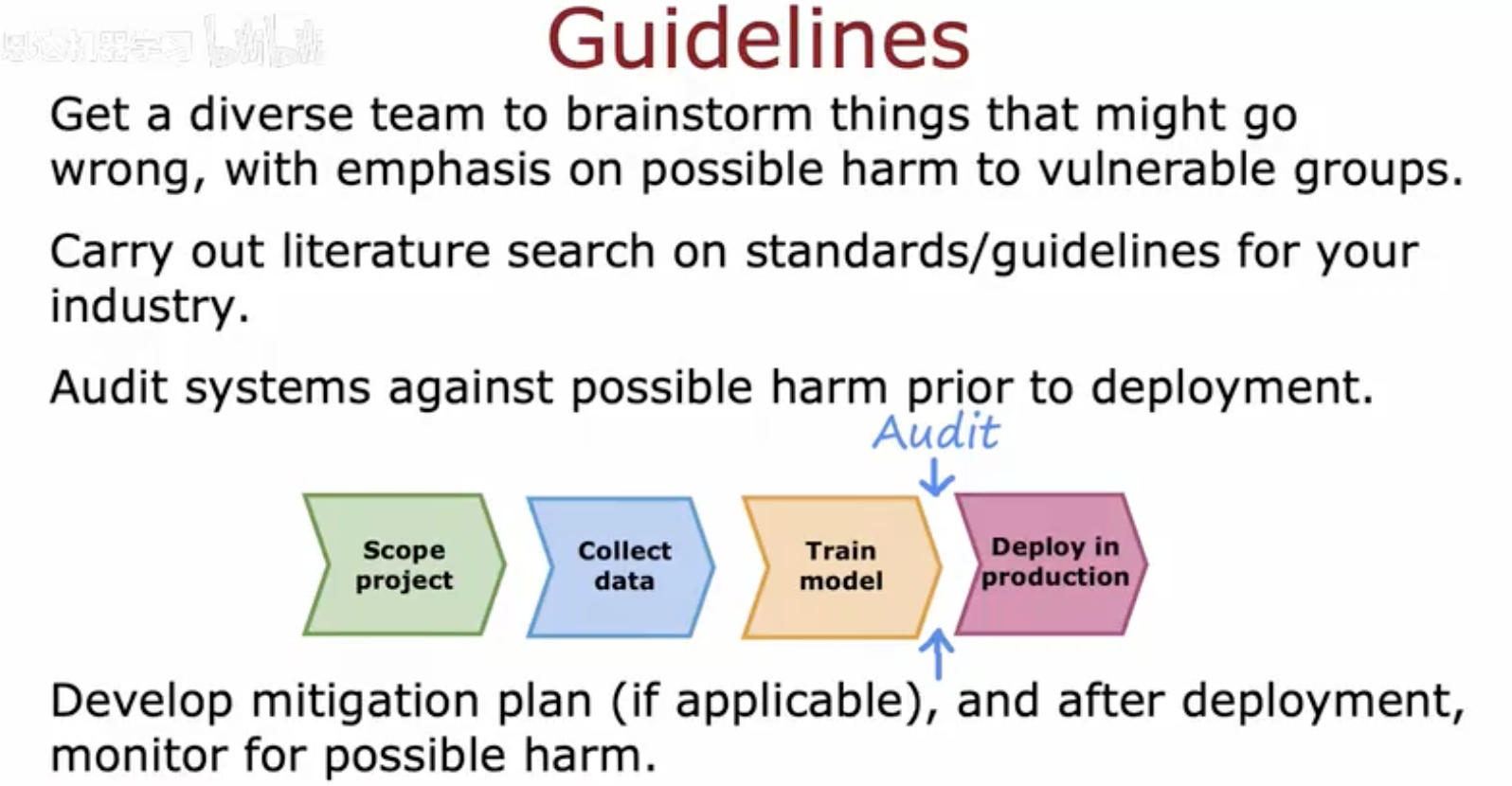

四、机器学习项目实施指导原则

这幅图片提供了关于机器学习项目实施过程中的指导原则:

组建一个多样化的团队来集思广益,特别关注可能对弱势群体造成伤害的问题。

对你的行业进行文献搜索,了解相关的标准和指导方针。

在部署前对系统进行审计,以防止可能的伤害。

制定缓解计划(如果适用),并在部署后监控可能的伤害。

图片中还展示了一个流程图,包括项目范围定义、数据收集、模型训练和生产部署等步骤,并在部署前有一个审计环节。