一、引言

数据挖掘(Data Mining)是现代数据分析的重要组成部分,它的核心目标是从大量数据中提取潜在的、有用的知识与规律。随着大数据与人工智能的发展,数据挖掘已成为企业决策、科学研究与社会治理的重要支撑技术。

从广义上看,数据挖掘是一种将数据转化为信息、再将信息转化为知识的过程。它不仅关注结果预测,也关注模式发现;既涉及统计学与机器学习,也与数据库系统、人工智能等领域密切相关。

如上图所示,数据挖掘任务(Data Mining Tasks)大体可以分为四类:

预测建模(Predictive Modeling)

聚类分析(Clustering)

关联规则发现(Association Rule Discovery)

异常检测(Anomaly Detection)

这些任务共同构成了数据挖掘的核心框架。它们的目标虽各不相同,但都围绕一个中心思想——通过分析历史数据来揭示潜在模式或预测未来行为。

上图展示了数据挖掘中各主要任务之间的关系。数据是整个系统的核心,各种算法与分析方法围绕数据展开。例如,预测建模(Predictive Modeling)通过建立模型预测结果;聚类(Clustering)负责将相似的数据点分组;关联规则(Association Rules)揭示隐藏的关系;异常检测(Anomaly Detection)用于识别不符合常规的数据点。这些方法协同作用,共同构成了完整的数据挖掘体系。

二、预测建模(Predictive Modeling)

预测建模(Predictive Modeling)是数据挖掘中最核心的任务之一,其主要目标是利用历史数据建立数学模型,从而对未知或未来的数据进行预测。预测建模可分为两大类:分类(Classification)与回归(Regression)。前者用于预测离散型结果,后者则用于预测连续型数值。

上图展示了一个典型的分类任务。模型通过分析历史数据中各属性之间的关系,找到能预测“信用是否良好(Credit Worthy)”的模式。例如,模型会发现“是否就业”“教育水平”“居住年限”等变量与信用状况之间的对应关系。图中的决策树(Decision Tree)直观地表示了这种决策逻辑:若一个人已就业且受过高等教育,则其信用良好的概率更高。这类模型被广泛用于信用风险评估、垃圾邮件识别、医学诊断等场景。

与分类不同,回归(Regression)任务的目标是预测连续值变量。它通常假设一个自变量与因变量之间的函数关系,可能是线性的,也可能是非线性的。上图中展示了回归分析的基本思想:通过建模数据间的依赖关系来预测未来数值。

例如,企业可以根据广告支出预测销售额;气象部门可以利用温度、湿度和气压等数据预测风速;股票分析模型则可基于时间序列数据预测市场指数的变化。这些应用的共同特征是:它们都在已有数据的基础上,试图找到一种可推广的规律,以便预测未来的趋势或结果。

预测建模的成功依赖于数据质量与模型选择。对于分类问题,常见算法包括决策树、支持向量机、随机森林和神经网络;而在回归任务中,线性回归、多项式回归以及深度学习模型都是常用的工具。无论采用哪种算法,预测建模的最终目标都是让机器“学习”出数据背后的模式,从而实现更精准的推断与决策。

三、聚类分析(Clustering)

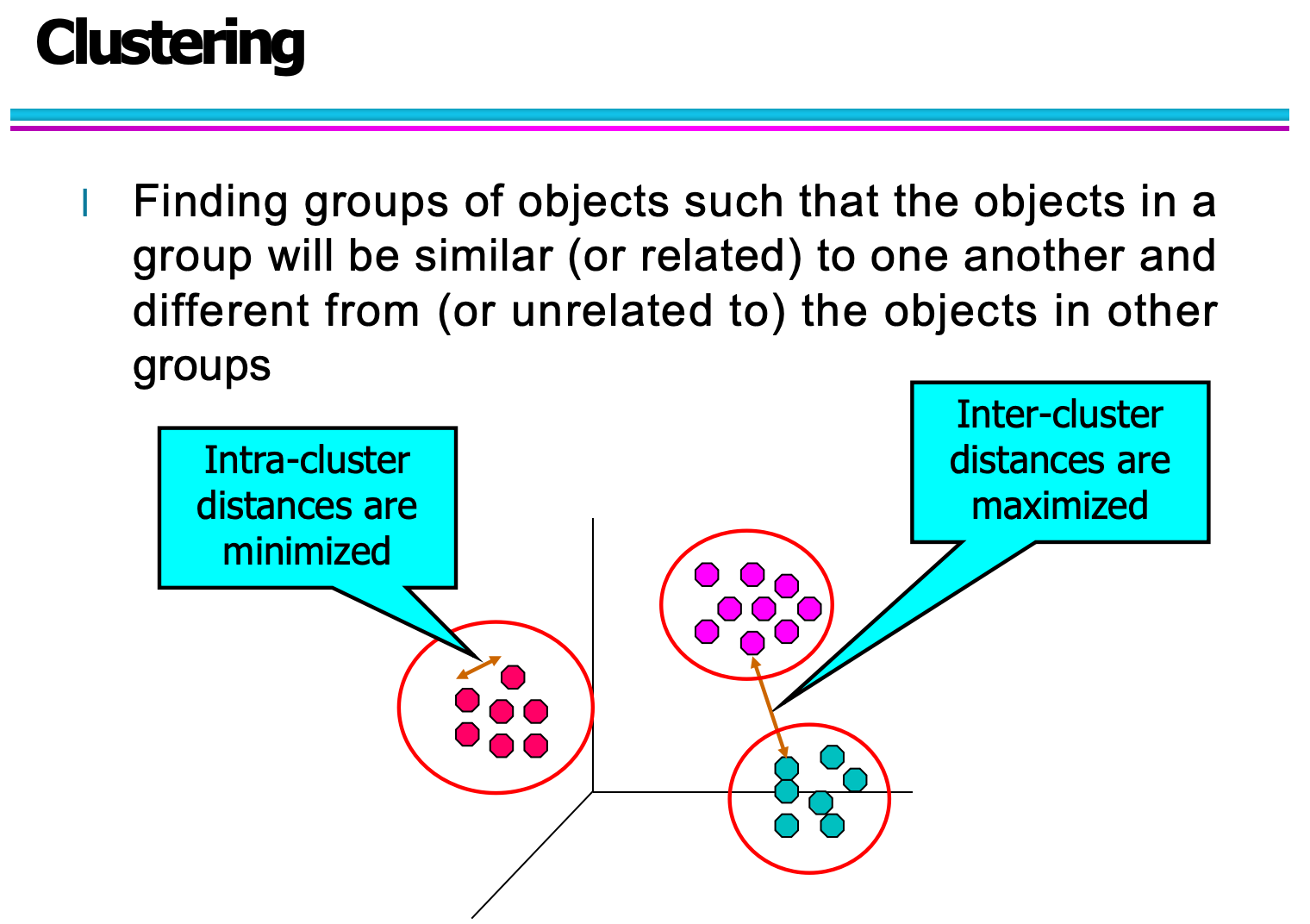

聚类分析(Clustering)是一种无监督学习(Unsupervised Learning)方法,其主要目标是将一组对象划分为若干组(簇,Clusters),使得同一组中的对象相似度高,而不同组之间的差异显著。换句话说,它试图在没有预先标签的情况下,发现数据的自然结构或隐藏模式。

如上图所示,聚类的核心思想可以用“簇内距离最小化(Intra-cluster distances are minimized)”和“簇间距离最大化(Inter-cluster distances are maximized)”来概括。图中不同颜色的点代表属于不同簇的数据对象。每个簇内部的点彼此接近,而簇与簇之间则保持较大的间距。这种关系常常通过欧氏距离、曼哈顿距离或余弦相似度等度量方法来计算。

聚类算法的类型多种多样,其中最经典的代表是 K-Means 聚类。该算法通过迭代方式寻找最佳簇中心,使得每个数据点与其最近的中心点之间的平方距离之和最小。除此之外,还有层次聚类(Hierarchical Clustering)、基于密度的 DBSCAN、以及基于模型的高斯混合模型(GMM)等方法,它们各自适用于不同的数据特征与任务目标。

在实际应用中,聚类分析被广泛应用于多个领域。例如:

在市场营销中,可以根据客户的消费行为将群体细分,从而实现精准营销;

在图像处理中,可以对像素点进行分组,用于目标识别或图像压缩;

在社会网络分析中,聚类可以揭示社群结构,发现用户群体之间的潜在联系。

可以说,聚类为数据提供了“结构化的视角”,帮助我们理解复杂数据集的内在规律,为后续的分析与决策提供依据。

四、关联规则发现(Association Rule Discovery)

关联规则发现(Association Rule Discovery)是一种用于揭示数据集中不同变量之间潜在关系的分析方法。它的核心思想是通过统计方法从海量事务数据中找出频繁共现的模式,用以解释“哪些项经常同时出现”。

上图展示了一个典型的购物篮分析(Market Basket Analysis)场景。每一行代表一次顾客的购买记录,每列表示某种商品(如牛奶、尿布、啤酒等)。通过分析这些交易数据,我们可以发现某些商品之间存在潜在关联——例如“购买尿布的人往往也会购买啤酒”。这种规律就可以用关联规则(Association Rule)的形式表示:

尿布⇒啤酒尿布⇒啤酒

其中,两个关键指标用于衡量规则的强度:

支持度(Support):表示某规则在整个数据集中出现的频率。例如,若100笔交易中有20笔同时购买了尿布和啤酒,则该规则的支持度为20%。

置信度(Confidence):表示在购买尿布的顾客中,有多少比例同时购买了啤酒。如果在50个买尿布的顾客中有20个也买了啤酒,则置信度为40%。

除了这两个基本指标,现代数据挖掘还引入了提升度(Lift)来衡量规则的独立性。如果某条规则的提升度大于1,说明两个事件之间存在正相关关系;若小于1,则说明它们之间可能存在负相关。

关联规则发现的经典算法是 Apriori算法,它通过逐步扩大项集来挖掘频繁模式。后来出现的 FP-Growth算法则通过构建压缩结构(频繁模式树)大幅提升了计算效率。

在现实应用中,关联规则不仅用于零售行业,还广泛应用于:

推荐系统:根据用户的历史行为推荐相关产品;

医疗数据分析:发现疾病与症状、药物之间的共现关系;

网络安全:识别常见攻击模式的特征组合。

通过发现这些隐含的“因果式”关系,企业能够更好地理解用户行为,优化决策,甚至提前预测未来的市场趋势。

五、异常检测(Anomaly Detection)

异常检测(Anomaly Detection)是数据挖掘中的另一项关键任务,其目标是识别那些与大多数数据模式明显不同的样本或事件。这些异常点通常代表潜在的重要信息,例如欺诈行为、系统故障、安全威胁或罕见事件。

上图展示了异常检测的直观概念:在一个数据分布图中,大多数点聚集在特定区域,形成“正常模式”;而少数孤立、远离密集区域的点则被视为“异常点”。这些点之所以重要,是因为它们往往揭示了系统中被忽视的问题或潜在风险。

异常检测方法主要可分为三类:

基于统计的方法(Statistical Methods)

假设数据服从某种概率分布(如正态分布),当某个样本的概率密度显著低于阈值时,即被判定为异常。例如,在银行交易中,如果某用户的消费金额远超其历史均值,就可能被标记为可疑交易。基于距离或密度的方法(Distance/Density-based Methods)

这类方法基于相似性或不相似性度量来判断异常。若某个样本点与其他样本的平均距离过大,或其局部密度显著低于周围点,则被认为是异常点。代表性算法包括 LOF(Local Outlier Factor) 和 DBSCAN。基于机器学习的方法(Machine Learning-based Methods)

在复杂场景中,异常可能并不遵循简单的统计模式。此时可以利用监督或无监督学习模型,例如自编码器(Autoencoder)、孤立森林(Isolation Forest)等,通过学习数据的正常分布特征来自动检测异常。

异常检测在实际应用中极具价值:

在金融领域,用于信用卡欺诈检测、洗钱风险识别;

在网络安全中,用于识别入侵行为或异常流量;

在工业监控中,可用于设备故障预警与生产质量控制;

在医疗领域,可辅助识别罕见病症或异常检测结果。

总的来说,异常检测让我们能够“关注少数”,从正常数据的海洋中识别出那些看似微小却至关重要的异常模式,为系统安全与智能决策提供关键支持。

六、结论

通过前几章的内容,我们可以看到,数据挖掘任务构成了从数据中提取知识的完整体系。它既包括预测类任务(如分类与回归),也包括模式发现类任务(如聚类与关联规则),同时还涵盖了风险识别类任务(如异常检测)。这些不同类型的分析共同服务于一个目标——让数据真正“发声”,为决策提供科学依据。

在预测建模中,我们利用已有数据建立模型,预测未来结果或未知状态;在聚类分析中,我们揭示数据的内在结构与群体分布;在关联规则发现中,我们挖掘潜在的行为联系和逻辑关系;而在异常检测中,我们识别出隐藏在数据中的特殊模式或风险信号。这些任务既各自独立,又相互关联,共同支撑着数据驱动的智能决策体系。

从更宏观的角度来看,数据挖掘的意义不仅在于“计算”,更在于“理解”。它帮助人类从复杂、多维的数据中提炼出可解释的规律,从而提升企业的运营效率、优化社会资源配置,甚至推动科学研究的发展。如今,在人工智能与大数据技术的推动下,数据挖掘正不断演化,从传统的统计分析走向自动化与智能化,成为认知世界与预测未来的重要工具。

未来,随着数据规模的持续增长与算法的持续优化,数据挖掘的边界将被进一步拓宽。无论是商业决策、社会治理,还是科学探索,数据挖掘都将继续发挥不可替代的作用。它不仅是一门技术,更是一种方法论——一种以数据为基础理解世界的思维方式。