一、熵的定义

熵是信息论中的一个概念,用于衡量信息的不确定性或混乱程度。在机器学习中,熵常用来评估数据集的纯度,即数据集中样本属于同一类别的程度。

通俗理解:

熵越高,表示数据越混乱,分类越困难;熵越低,数据越有序,分类越容易。

二、熵与样本纯度的关系

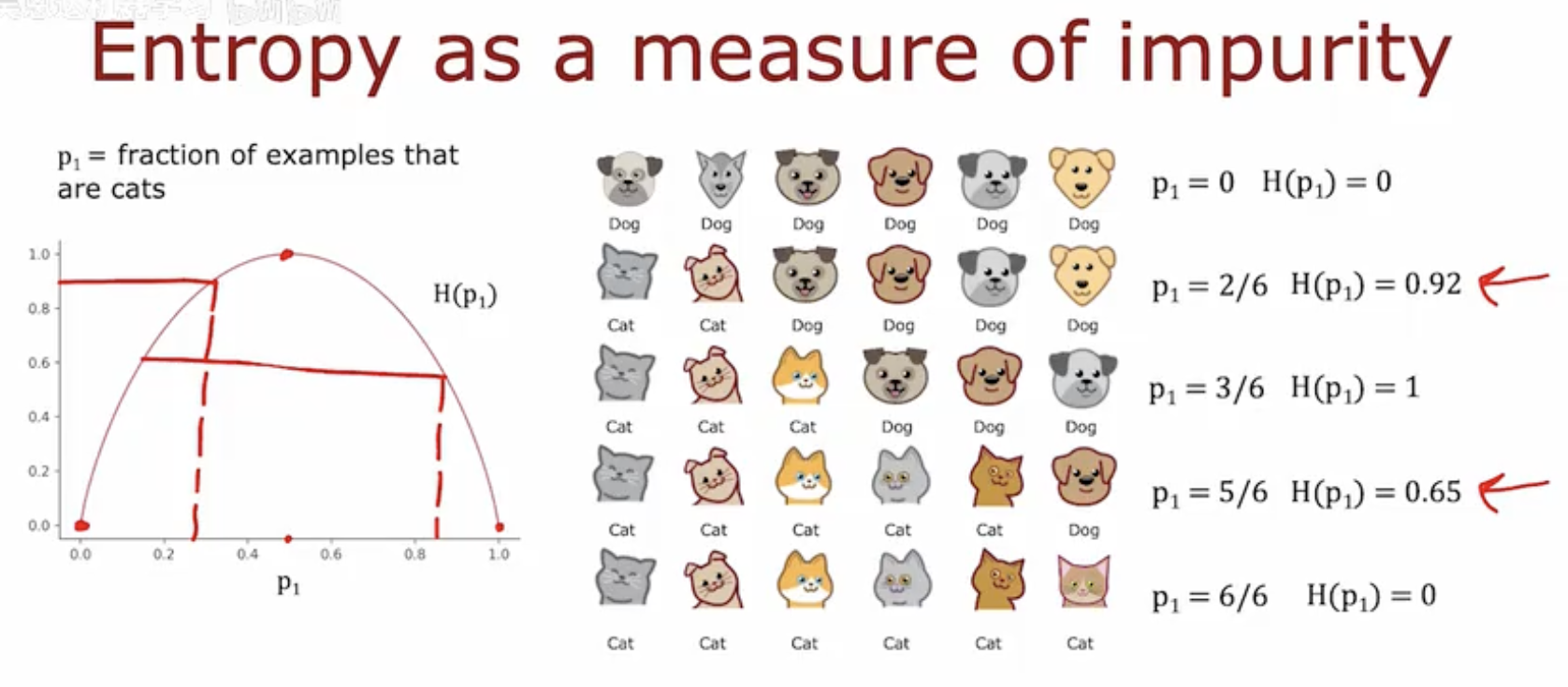

图片左侧(熵的图形表示):

横轴(p1):表示样本中猫的比例。

纵轴(H(p1)):表示熵的值,熵是衡量样本集合纯度的指标。

曲线:展示了熵随猫的比例变化的情况。当所有样本都是猫(p1 = 1)或都是狗(p1 = 0)时,熵为0,表示纯度最高。当样本中猫和狗的比例接近时,熵达到最大值,表示纯度最低。

图片右侧(不同概率分布的例子):

p1 = 0:所有样本都是狗,熵为0。

p1 = 2/6:样本中有2只猫和4只狗,熵为0.92。

p1 = 3/6:样本中有3只猫和3只狗,熵为1。

p1 = 5/6:样本中有5只猫和1只狗,熵为0.65。

p1 = 6/6:所有样本都是猫,熵为0。

这些例子展示了不同比例的猫和狗时,熵的值如何变化。熵的值反映了样本集合的纯度,熵越高,纯度越低;熵越低,纯度越高。

三、熵与不纯度的计量

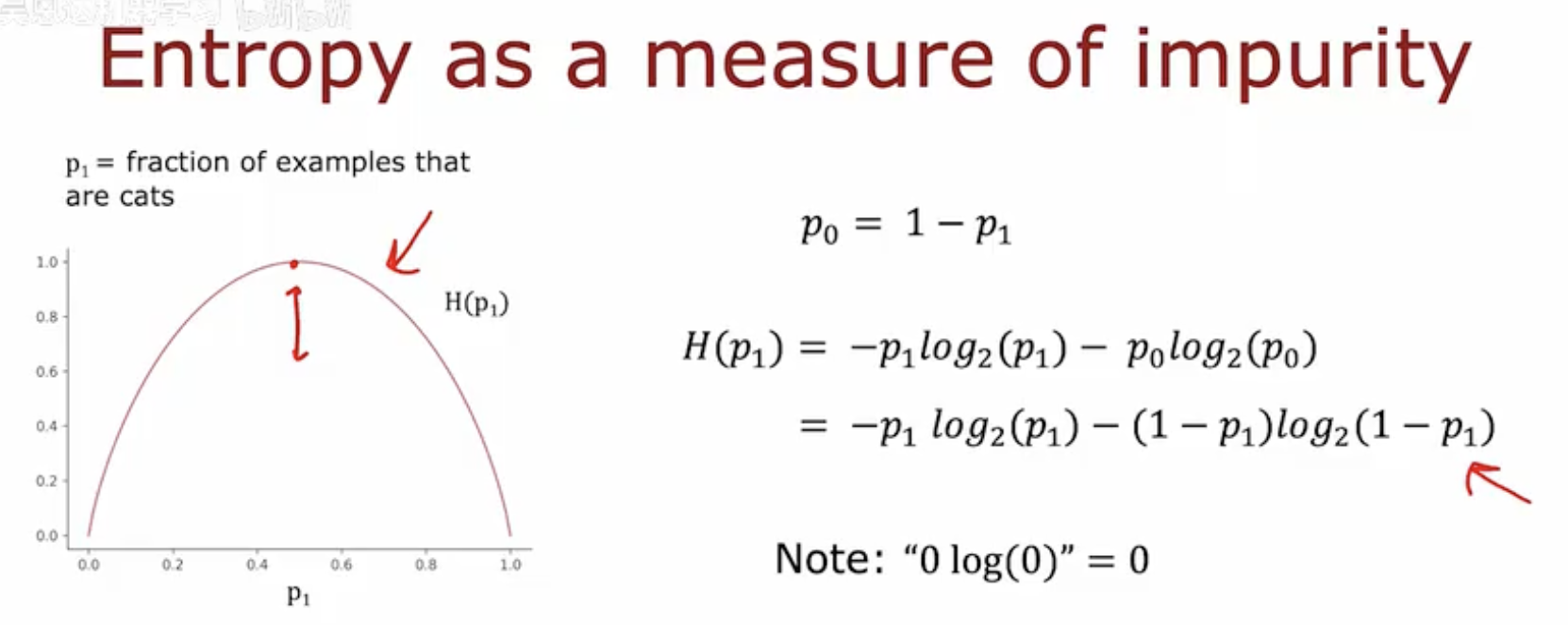

图表部分:

图表的横轴表示 p1,即样本中属于某一类别(例如猫)的比例。

纵轴表示 H(p1),即信息熵的值,它量化了样本集合的不纯度。

图表中的曲线展示了熵随 p1 变化的趋势。曲线呈现出一个钟形,表明当样本完全属于一个类别(p1=0 或 p1=1)时,熵为0,表示纯度最高;当样本均匀分布(p1=0.5)时,熵达到最大值,表示纯度最低。

公式部分:

p0 = 1−p1 表示样本中属于另一类别(例如狗)的比例。

熵的计算公式为 H(p1)=−p1log2(p1)−p0log2(p0),其中 log2 表示以2为底的对数。

公式可以简化为 H(p1)=−p1log2(p1)−(1−p1)log2(1−p1),这表明熵是两个类别概率的函数。

备注说明 0log(0)=0,这是对数函数的一个性质,用于处理概率为0的情况。

这幅图通过图表和公式展示了信息熵如何量化样本集合的不纯度,其中熵值越高,表示样本集合的不纯度越高。

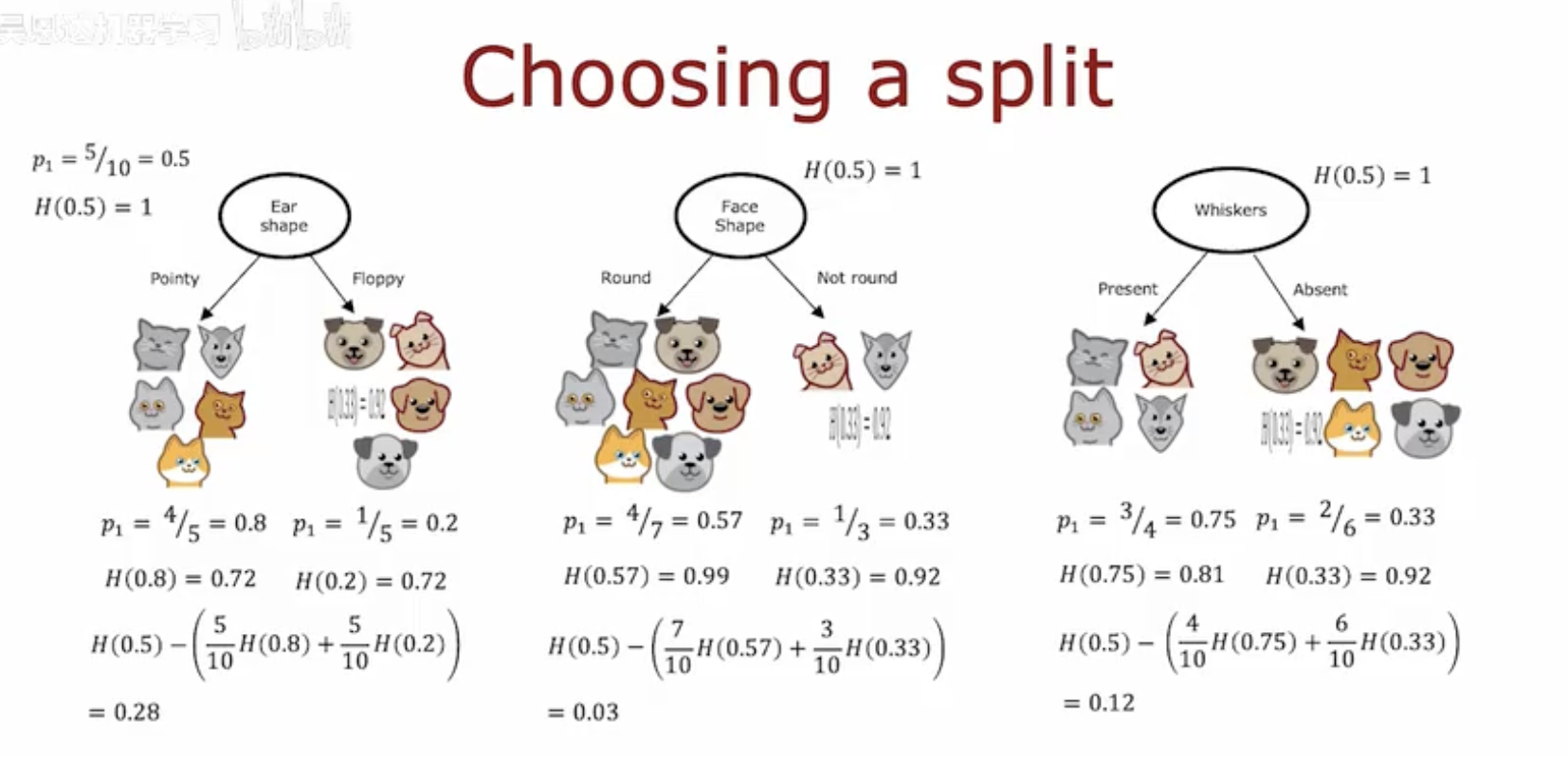

四、决策树分裂属性的信息增益计算

这幅图展示了如何通过计算信息增益来选择决策树的最佳分裂属性。

初始状态:

初始样本集的猫的比例 p1=5/10=0.5,熵 H(0.5)=1。

耳形(Ear shape)分裂:

耳形分为“尖耳(Pointy)”和“垂耳(Floppy)”两类。

尖耳类别中,猫的比例 p1=4/5=0.8,熵 H(0.8)=0.72。

垂耳类别中,猫的比例 p1=1/5=0.2,熵 H(0.2)=0.72。

计算信息增益:H(0.5)−(5/10 H(0.8)+5/10 H(0.2))=0.28。

脸型(Face shape)分裂:

脸型分为“圆脸(Round)”和“非圆脸(Not round)”两类。

圆脸类别中,猫的比例 p1=4/7≈0.57,熵 H(0.57)=0.99。

非圆脸类别中,猫的比例 p1=1/3≈0.33,熵 H(0.33)=0.92。

计算信息增益:H(0.5)−(7/10 H(0.57)+3/10 H(0.33))=0.03。

胡须(Whiskers)分裂:

胡须分为“有胡须(Present)”和“无胡须(Absent)”两类。

有胡须类别中,猫的比例 p1=3/4=0.75,熵 H(0.75)=0.81。

无胡须类别中,猫的比例 p1=2/6=0.33,熵 H(0.33)=0.92。

计算信息增益:H(0.5)−(4/10 H(0.75)+6/10 H(0.33))=0.12。

总结:通过计算不同分裂属性的信息增益,可以选择信息增益最大的属性作为决策树的最佳分裂点。在这个例子中,耳形分裂的信息增益最大,为0.28。