一、XGBoost算法的定义

XGBoost(eXtreme Gradient Boosting)是一种高效的机器学习算法,基于梯度提升框架。它通过组合多个弱学习器(通常是决策树)来构建强大的预测模型,每次迭代都会针对前一次模型的残差进行学习,从而逐步提高模型的准确性。XGBoost 在处理大规模数据集时表现出色,具有高效的计算性能和良好的可扩展性,并且能够自动处理缺失值。此外,它还提供了多种正则化选项,有助于防止模型过拟合。

通俗理解:

XGBoost 就像是一个由多个小专家组成的团队,每个小专家都有一定的判断能力,但可能不够准确。XGBoost 让这些小专家一个接一个地发表意见,后面的专家会根据前面专家的不足之处进行补充和修正,最终团队的综合判断会非常准确。

二、Boosted Trees 算法流程图解

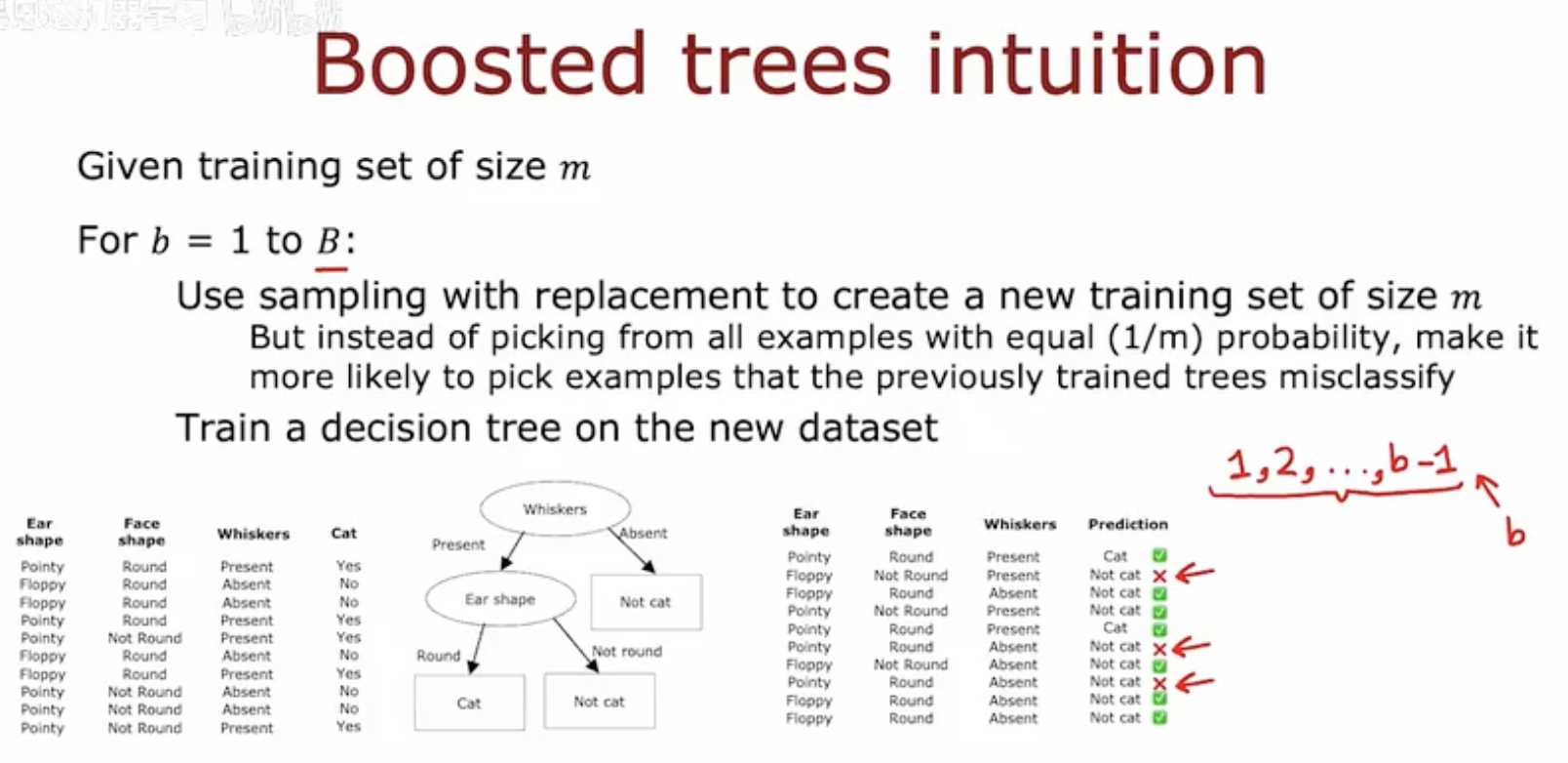

这幅图展示了提升树(Boosted Trees)算法的直观理解。图中描述了以下步骤:

给定一个大小为 m 的训练集。

对于 b=1 到 B:

使用有放回的抽样创建一个新的大小为 m 的训练集。

但不是以等概率 (1/m) 从所有样本中抽取,而是更有可能选择之前训练的树错误分类的样本。

在新数据集上训练一个决策树。

图中还展示了一个决策树的例子,根据猫的耳朵形状、面部形状和胡须的存在与否来预测猫的类别。右侧的表格显示了不同样本的特征和预测结果,其中一些预测是错误的(用红色叉号标记)。这些错误分类的样本在后续迭代中会被更频繁地选中,以便模型能够更好地学习这些难以分类的样本。

三、XGBoost算法特点

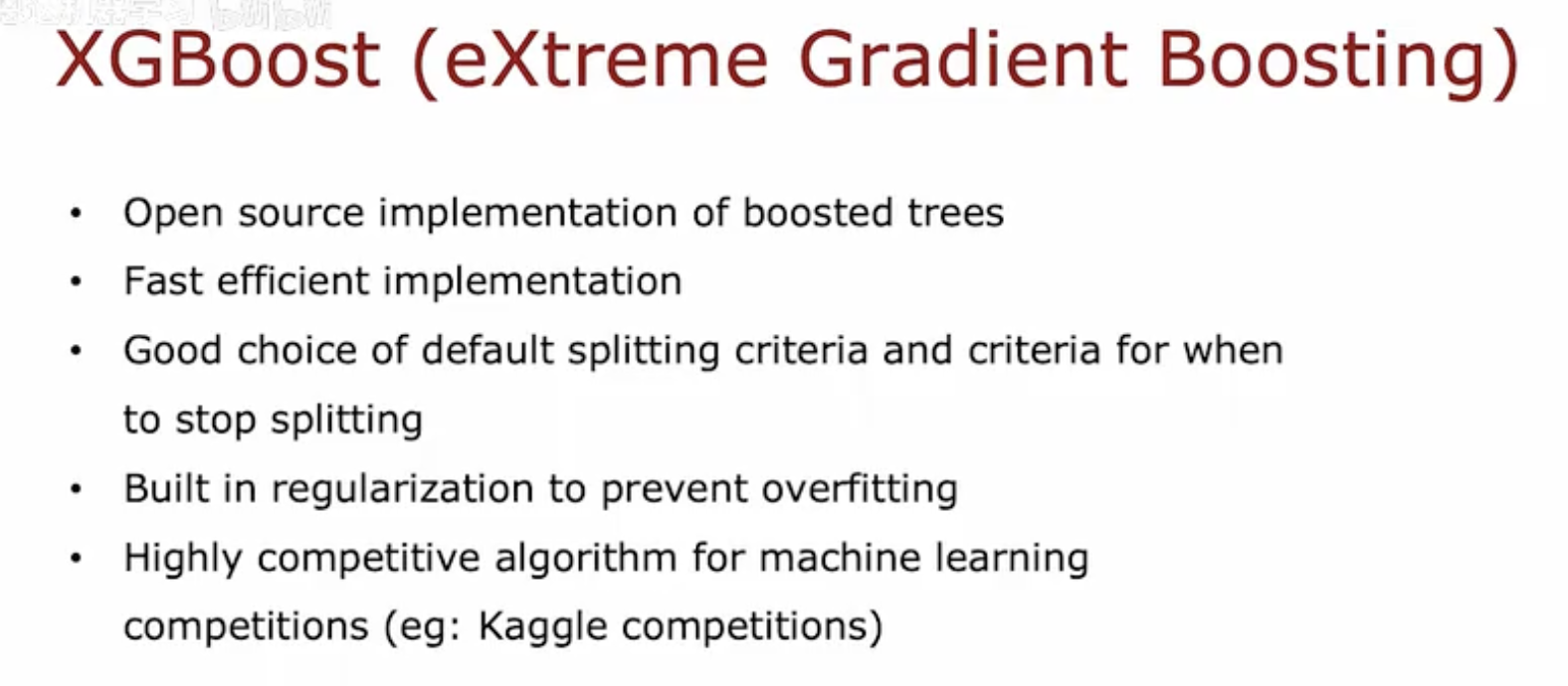

这幅图列出了XGBoost(eXtreme Gradient Boosting)的几个关键特点:

开源实现的增强树:XGBoost是一个开源的机器学习库,提供了增强树的实现。

快速高效的实现:XGBoost以其快速和高效的算法实现而闻名。

默认分裂标准和停止分裂标准的良好选择:XGBoost提供了默认的分裂和停止分裂的标准,这些标准通常能够很好地工作。

内置正则化以防止过拟合:XGBoost内置了正则化机制,有助于减少模型的过拟合风险。

在机器学习竞赛中极具竞争力的算法:XGBoost在各种机器学习竞赛(例如Kaggle竞赛)中表现出色,是一个极具竞争力的算法。

四、XGBoost 分类与回归模型使用

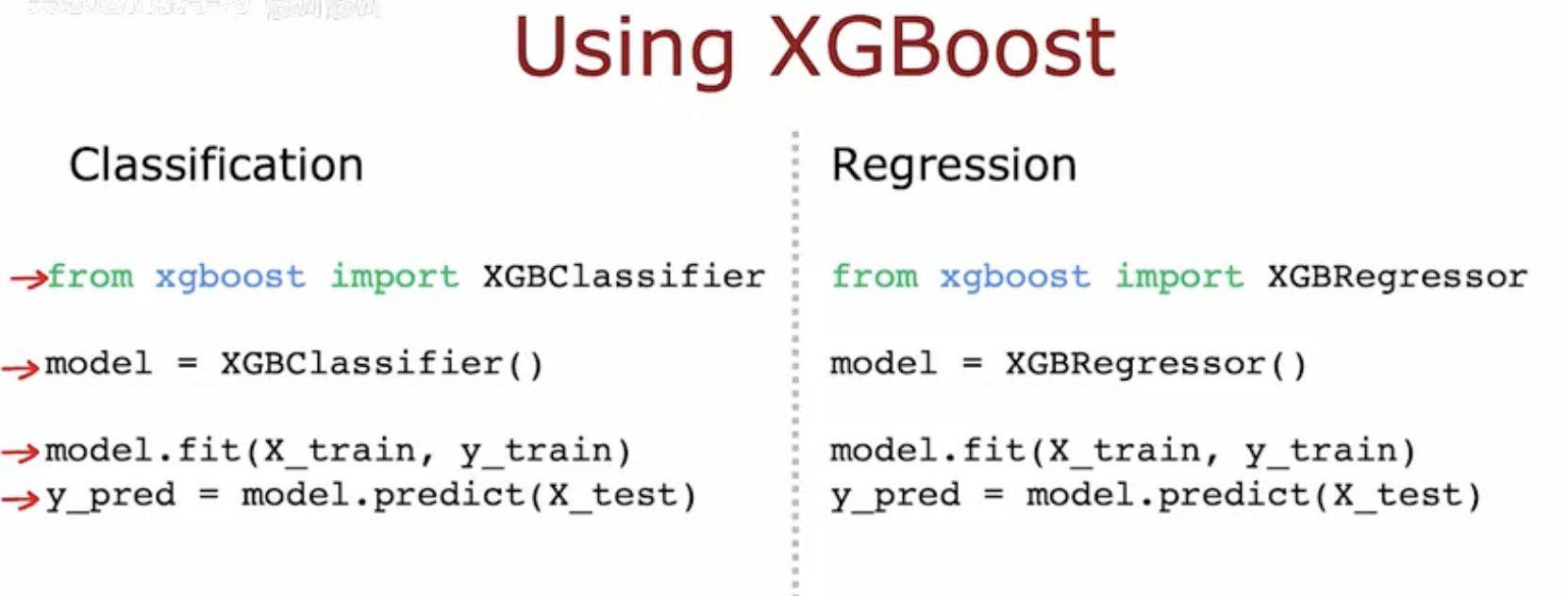

这幅图展示了如何使用XGBoost进行分类和回归任务的基本代码示例。

分类任务:

首先,从

xgboost库中导入XGBClassifier。然后,创建一个

XGBClassifier模型实例。使用

model.fit(X_train, y_train)训练模型,其中X_train是训练数据的特征,y_train是训练数据的目标变量。使用

model.predict(X_test)对测试数据X_test进行预测,得到预测结果y_pred。

回归任务:

首先,从

xgboost库中导入XGBRegressor。然后,创建一个

XGBRegressor模型实例。使用

model.fit(X_train, y_train)训练模型,其中X_train是训练数据的特征,y_train是训练数据的目标变量。使用

model.predict(X_test)对测试数据X_test进行预测,得到预测结果y_pred。